自然语言处理是人工智能领域中的重要研究方向之一,其中机器翻译作为自然语言处理的重要应用之一,一直以来都是学术界和工业界关注的焦点。近年来,Transformer模型以其性的思想和出色的翻译效果引起了广泛关注。本文将深入解析Transformer翻译原理,从Seq2Seq模型的缺陷到Transformer的创新之处,探讨了其为什么成为自然语言处理领域的新宠,并分析了其优势和局限性。

Seq2Seq模型的问题与Transformer的提出(Seq2Seq模型)

1.Seq2Seq模型的概述和基本原理(Encoder-Decoder结构、编码器和解码器)

2.Seq2Seq模型的局限性(长距离依赖、信息丢失、无法并行化等问题)

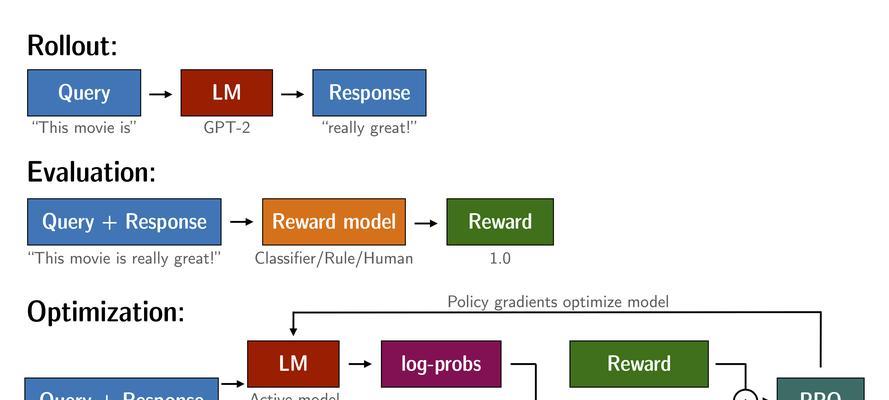

3.Transformer模型的提出(Attention机制、Self-Attention机制)

Transformer模型的核心组成部分

4.Self-Attention机制(注意力机制、查询、键、值、注意力权重计算)

5.多头注意力机制(为什么需要多头、注意力权重的计算)

6.位置编码(为什么需要位置编码、位置编码的计算方法)

Transformer模型的训练与推理

7.模型训练过程(损失函数、反向传播、优化器)

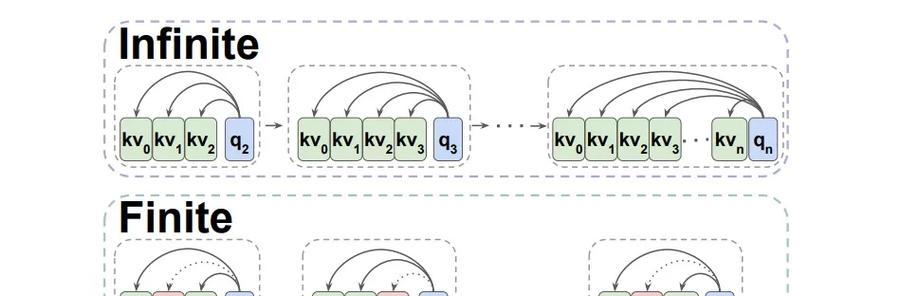

8.推理过程(自回归推理、无TeacherForcing推理)

9.BeamSearch算法(解码器的贪婪搜索和束搜索)

Transformer模型的优势与应用

10.并行计算能力(Self-Attention的并行计算、硬件加速)

11.长距离依赖关系建模能力(Self-Attention的优势)

12.基于Transformer的机器翻译应用案例

Transformer模型的局限性与发展

13.训练时间和资源需求(模型规模、训练时间和计算资源关系)

14.外部知识融入(Transformer模型的扩展和改进)

15.Transformer模型未来的发展方向和挑战

通过对Transformer翻译原理的深入解析,我们了解到其性的思想和出色的翻译效果,使其成为自然语言处理领域的新宠。Transformer模型通过引入Self-Attention机制和多头注意力机制,克服了Seq2Seq模型的缺陷,具备了更好的建模能力和并行计算能力。然而,Transformer模型仍存在训练时间和资源需求大、外部知识融入等局限性。未来,我们可以进一步探索Transformer模型的发展方向,解决其局限性,并将其应用到更多自然语言处理任务中。